K-means聚类算法

分类: MLTTyb 2017-01-04 1893

K-means算法是硬聚类算法,是典型的基于原型的目标函数聚类方法的代表,它是数据点到原型的某种距离作为优化的目标函数,利用函数求极值的方法得到迭代运算的调整规则。K-means算法以 欧式距离 作为相似度测度,它是求对应某一初始聚类中心向量V最优分类,使得评价指标J最小。算法采用 误差平方和 准则函数作为聚类准则函数。K-means 百度百科

K-means聚类算法的实质简单来说就是 两点间的距离 ,计算步骤为:

第一步–获取坐标点

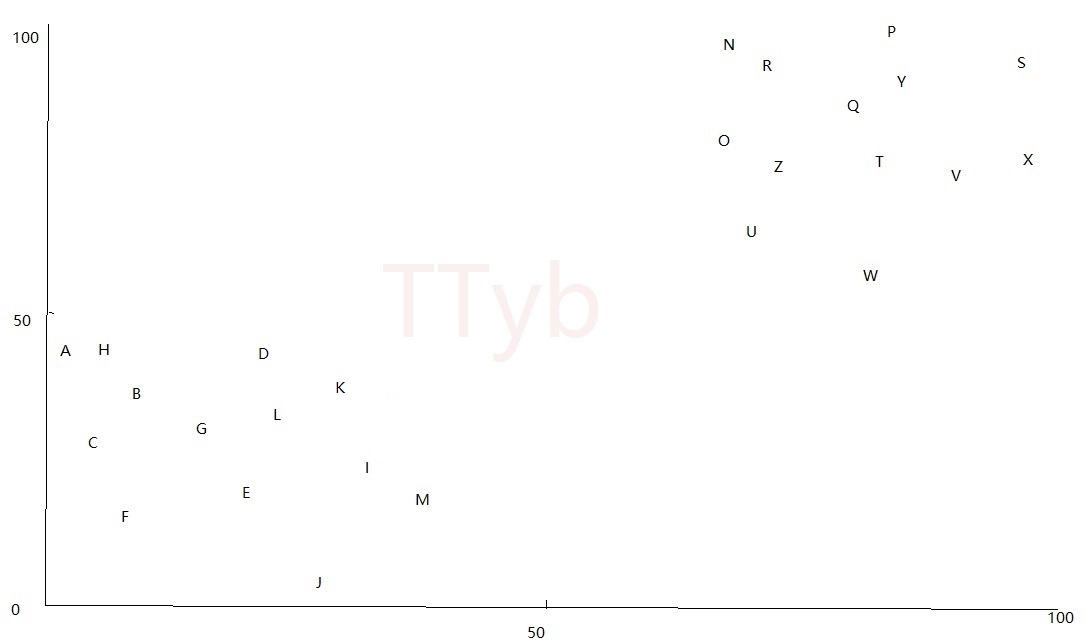

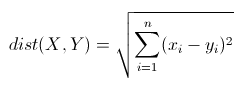

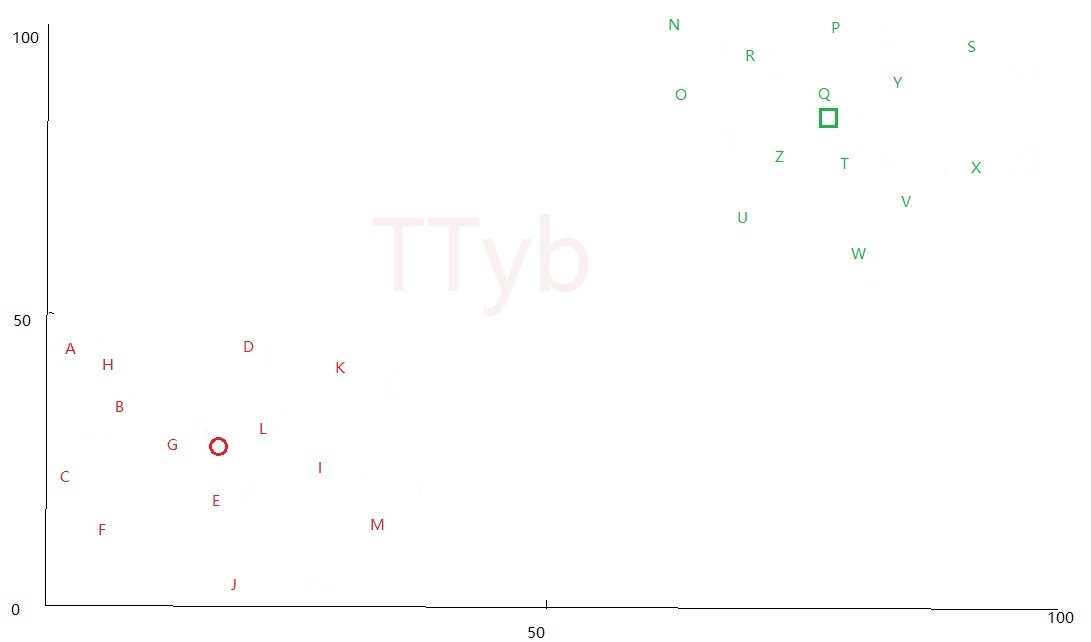

本文随机生成26个字母在 0-100 的坐标点:

{'V': {'y': 81, 'x': 61}, 'H': {'y': 19, 'x': 37}, 'X': {'y': 93, 'x': 66}, 'S': {'y': 81, 'x': 89}, 'E': {'y': 23, 'x': 39}, 'T': {'y': 81, 'x': 70}, 'Q': {'y': 87, 'x': 96}, 'K': {'y': 39, 'x': 37}, 'A': {'y': 14, 'x': 7}, 'B': {'y': 6, 'x': 17}, 'I': {'y': 15, 'x': 32}, 'W': {'y': 83, 'x': 78}, 'J': {'y': 20, 'x': 21}, 'R': {'y': 81, 'x': 74}, 'Y': {'y': 89, 'x': 65}, 'M': {'y': 1, 'x': 24}, 'Z': {'y': 62, 'x': 78}, 'D': {'y': 0, 'x': 0}, 'U': {'y': 65, 'x': 98}, 'O': {'y': 73, 'x': 75}, 'C': {'y': 8, 'x': 20}, 'F': {'y': 36, 'x': 38}, 'L': {'y': 38, 'x': 12}, 'G': {'y': 34, 'x': 10}, 'P': {'y': 69, 'x': 90}}

刻画在坐标图上为:

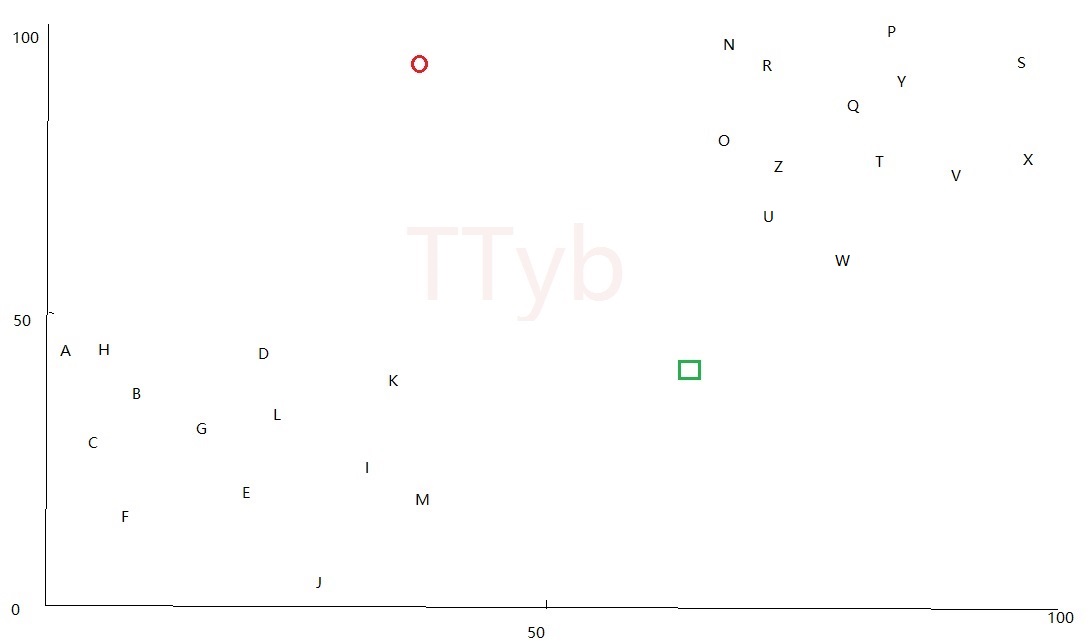

第二步–生成质点

质点也就是上图中 分簇的中心点 ,质点的个数也就是 K值 ,K=2则代表有两个分簇,也就是说有两个分簇的质点,K=3则代表有三个分簇,也就是说有三个分簇的质点。

但是最开始并不知道中心点的坐标,因此最开始生成质点的方式有两种:

- 以某两个字母的坐标点作为质点,这两个字母是随机选择的

- 在0-100内随机生成两个坐标点作为质点

上图中是以方法二得到的两个质点,分别是 红色的圆 和 绿色的框

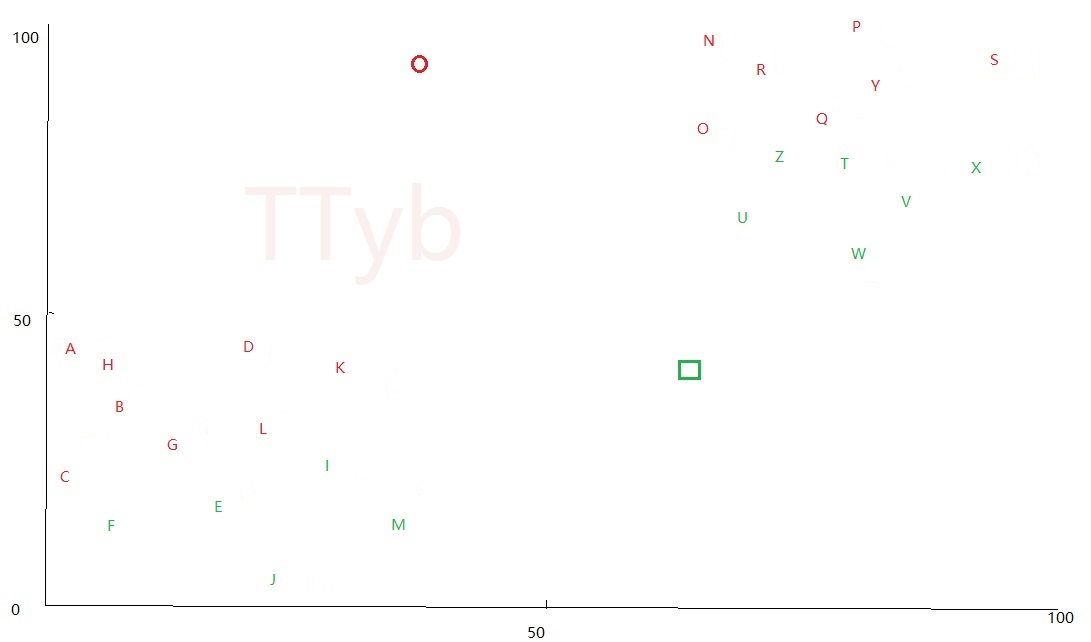

第三步–第一次分簇

分簇需要计算两个间的距离,利用欧几里得距离可以求得:

在上图中,假设一个坐标点 A点 , A点 和 红色的圆 的距离小于 A点 和 绿色的框 的距离,那么认为A点属于 红色的圆 的分簇;同理,M点 和 红色的圆 的距离大于 M点 和 绿色的框 的距离,那么认为M点属于 绿色的框 的分簇,第一次分簇得到的图形如下:

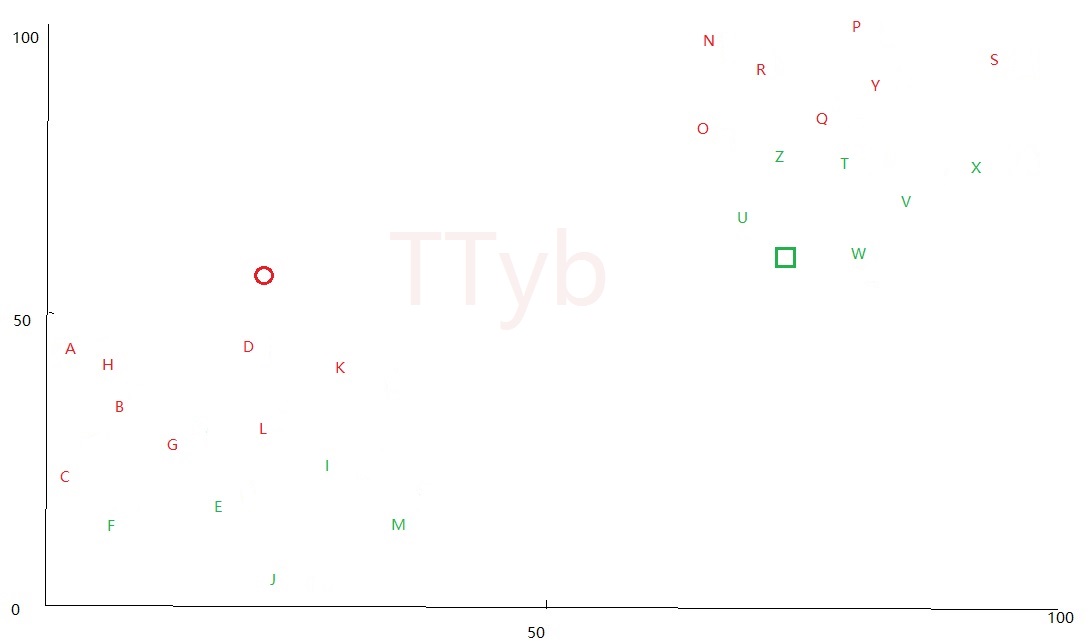

第四步–更新质点

从上图看出分簇很不合理,原因是最开始的质点是 随机 生成的,这里需要更新质点,更新的办法 简单粗暴 :

1. 得到所有红色字母的横、纵坐标

2. 分别计算横、纵坐标的平均值,平均值即为新的红色质点坐标

3. 绿色字母同理

新的质点可能偏移到下列位置:

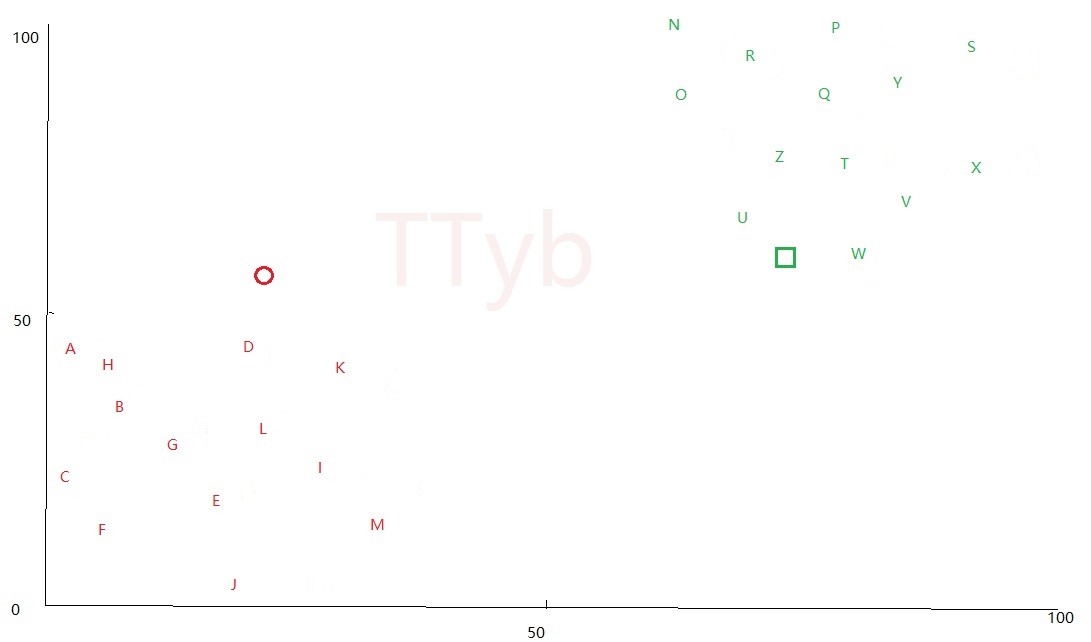

第五步–再次分簇

分簇的方法和 第三步 一样,可以得到如下形势:

第六步–再次更新质点

由于本文只是举例,虽然看起来分簇已经很完美了,但是质点并非处于簇的中心,这里还不算分簇完成,完成的标志是:

更新质点时,更新前和更新后的质点偏移很小,或者偏移值固定不变

为什么 偏移值固定不变 也是完成的标志?原因在 第四步 的平均大法上面,这个在作者写代码时发现的,读者需要自己去实践

根据这个完成的标志,最终的 质点位置 和 分簇图 为:

第一步–获取坐标点

python随机生成 0-100 的坐标点,为了计算方便,将部分横坐标设定在 (0, 40) ,将部分纵坐标设定在 (60, 100)

# 生成坐标字典

def buildclusters():

clusters = {}

keys = [chr(i) for i in range(ord('A'), ord('Z') + 1)]

# ['A', 'B', 'C', 'D', 'E', 'F', 'G', 'H', 'I', 'J', 'K', 'L', 'M', 'N', 'O', 'P', 'Q', 'R', 'S', 'T', 'U', 'V', 'W', 'X', 'Y', 'Z']

# 生成小数坐标

for i in range(0, int(len(keys) / 2)):

temp = {}

x = random.randint(0, 40)

y = random.randint(0, 40)

temp["x"] = x

temp["y"] = y

clusters[keys[i]] = temp

# 生成大数坐标

for i in range(int(len(keys) / 2), int(len(keys))):

temp = {}

x = random.randint(60, 100)

y = random.randint(60, 100)

temp["x"] = x

temp["y"] = y

clusters[keys[i]] = temp

return clusters

返回结果为:

# {'V': {'y': 81, 'x': 61}, 'H': {'y': 19, 'x': 37}, 'X': {'y': 93, 'x': 66}, 'S': {'y': 81, 'x': 89}, 'E': {'y': 23, 'x': 39}, 'T': {'y': 81, 'x': 70}, 'Q': {'y': 87, 'x': 96}, 'K': {'y': 39, 'x': 37}, 'A': {'y': 14, 'x': 7}, 'B': {'y': 6, 'x': 17}, 'I': {'y': 15, 'x': 32}, 'W': {'y': 83, 'x': 78}, 'J': {'y': 20, 'x': 21}, 'R': {'y': 81, 'x': 74}, 'Y': {'y': 89, 'x': 65}, 'M': {'y': 1, 'x': 24}, 'Z': {'y': 62, 'x': 78}, 'D': {'y': 0, 'x': 0}, 'U': {'y': 65, 'x': 98}, 'O': {'y': 73, 'x': 75}, 'C': {'y': 8, 'x': 20}, 'F': {'y': 36, 'x': 38}, 'L': {'y': 38, 'x': 12}, 'G': {'y': 34, 'x': 10}, 'P': {'y': 69, 'x': 90}}

第二步–生成质点

这里是 随机选取某两个点 作为初始的质点:

# 生成k个簇的质点/这里是以某个点为质点

def buildcluster(K):

centroids = {}

dic = buildclusters()

keys = []

for temp in dic.keys():

keys.append(temp)

for i in range(K):

rand = random.randint(0, len(keys) - 1)

name = "P" + str(i + 1)

centroids[name] = dic[keys[rand]]

# {'P1': {'y': 81, 'x': 79}, 'P2': {'y': 18, 'x': 5}}

return centroids

第三步–第一次分簇

需要欧几里得距离公式:

# 两点间的距离公式/欧式距离

def distance(x1, x2, y1, y2):

distan = ((x1 - x2) ** 2 + (y1 - y2) ** 2) ** 0.5

return distan

分簇的代码为:

# 分簇/簇点距离哪个质心最近就属于哪个质心的

def splitcluster(centroids, clusters, K):

# 分好的簇

newclusters = {}

# 新的质点

newcentroids = {}

# 分簇

# 26个点距离哪个质点的距离小

for key_clu in clusters.keys():

distan = {}

for key_cen in centroids.keys():

distan[key_cen] = distance(centroids[key_cen]["x"], clusters[key_clu]["x"], centroids[key_cen]["y"],

clusters[key_clu]["y"])

# 最小值的键值

name = "cluster" + minkey(distan).replace("P", "")

# 构造新字典

temp1 = clusters[key_clu]

try:

newclusters[name][key_clu] = temp1

except:

temp2 = {}

temp2[key_clu] = temp1

newclusters[name] = temp2

return newclusters

得到的结果为:

# {'cluster2': {'J': {'x': 0, 'y': 36}, 'V': {'x': 72, 'y': 98}, 'N': {'x': 82, 'y': 71}, 'P': {'x': 82, 'y': 73}, 'Q': {'x': 93, 'y': 81}, 'X': {'x': 68, 'y': 89}, 'R': {'x': 65, 'y': 60}, 'Z': {'x': 74, 'y': 89}, 'S': {'x': 99, 'y': 99}, 'D': {'x': 20, 'y': 40}, 'O': {'x': 72, 'y': 66}, 'W': {'x': 89, 'y': 82}}, 'cluster1': {'A': {'x': 37, 'y': 1}, 'E': {'x': 16, 'y': 4}, 'M': {'x': 18, 'y': 2}, 'I': {'x': 3, 'y': 11}, 'H': {'x': 2, 'y': 2}, 'L': {'x': 39, 'y': 27}, 'T': {'x': 97, 'y': 60}, 'U': {'x': 98, 'y': 72}, 'K': {'x': 21, 'y': 10}, 'C': {'x': 1, 'y': 16}, 'G': {'x': 31, 'y': 19}, 'B': {'x': 5, 'y': 22}, 'Y': {'x': 76, 'y': 62}, 'F': {'x': 11, 'y': 1}}}

第四步–更新质点

平均大法无敌:

# 根据簇的坐标得到新的质点

def getnewcentroids(dict):

centroids = {}

x = 0

y = 0

for key in dict.keys():

x += dict[key]["x"]

y += dict[key]["y"]

centroids["x"] = x / len(dict)

centroids["y"] = y / len(dict)

return centroids

更新质点:

# 更新质点

i = 0

for key in newclusters.keys():

tempdict = getnewcentroids(newclusters[key])

name = "P" + str(i + 1)

newcentroids[name] = tempdict

i += 1

第五、六步–再次分簇、更新质点

得到质点的差值:

# 得到质点差值

def centroidsoffset(centroids, newcentroids):

sum = 0

for key in centroids.keys():

sum += distance(centroids[key]["x"], newcentroids[key]["x"], centroids[key]["y"], newcentroids[key]["y"])

return sum

本文以如果质点差值不变,那么就算是最终的质点了:

while True:

newclusters, newcentroids, newdifference = splitcluster(newcentroids, clusters, K)

if tempdiff == newdifference:

print(newclusters)

print(newcentroids)

print(newdifference)

break

else:

tempdiff = newdifference

splitcluster(newcentroids, clusters, K)

源码下载:

如果你觉得本站内容有帮助

我要请作者喝杯咖啡博客作者

微信公众号

爬虫代码不知道怎么写

关注公众号让作者帮你解决!

博客热点

-

在使用 `import org.apache.spark.ml.feature.VectorAssembler` 转换特征后,想要放入 `import org.apache.spark.mllib.classification.SVMWithSGD` 去训练的时候出现错误 阅读全文 » -

Python3 打包exe方式 阅读全文 » -

《漫威》系列电影中,距离《复仇者联盟4》上映一周,豆瓣分都是8.1分的钢铁侠》和《复仇者联盟3》,《钢铁侠》有353695人评价打分,《复仇者联盟3》有557491人评价打分,这两部电影是否一样好看? 阅读全文 » -

昨天收到公众号粉丝的爬虫需求:抓取平台:天猫或者淘宝;爬取对象:某个商品的各分类的价格和库存数 阅读全文 » -

在flask页面下载excel 阅读全文 » -

java.lang.NoSuchMethodError: org.apache.spark.sql.DataFrameNaFunctions.fill(JLscala/collection/Seq;)Lorg/apache/spark/sql/Dataset 阅读全文 » -

import org.apache.spark.ml.feature.{HashingTF, IDF}库中,TFIDF结果的字段含义 阅读全文 » -

spark读CSV为Dataframe和spark将Dataframe写入CSV 阅读全文 » -

将dataframe利用pyspark列合并为一行,类似于sql的GROUP_CONCAT函数。spark和pyspark的方式不能共用 阅读全文 » -

想看下最近房价是否能入手,抓取链家二手房、新房的信息,发现广州有些精装修88平米的3房2厅首付只要 29 万,平均 1.1万/平,果然钱不够信息来凑,总能发现便宜的房子! 阅读全文 » -

hive新建分区表 阅读全文 » -

hive删除表和表中的数据,以及按分区删除数据 阅读全文 » -

csdn目前设置每日使用5次后必须登录才能看到阅读更多的内容,异常恶心。因此搜罗了方法去解决这个问题 阅读全文 » -

pandas和spark的dataframe互转 阅读全文 » -

需要将代码转换为html使其显示好看一些,可以在这里进行装换 阅读全文 » -

需要调用命令行来执行某些命令,主要是用subprocess实时获取结果和捕获错误,发现subprocess的很多坑 阅读全文 » -

ubuntu的vim取消缩进 阅读全文 » -

需要实现两台机器的信息交互,使用 `socket` 进行调度 阅读全文 » -

centos7开放端口和防火墙设置 阅读全文 » -

python获取set-cookies 阅读全文 » -

记录在TensorFlow中使用GPU的一些操作 阅读全文 » -

pandas的apply操作类似于Scala的udf一样方便 阅读全文 » -

将dataframe利用pandas列合并为一行,类似于sql的GROUP_CONCAT函数 阅读全文 » -

python读取了一个list是字符串形式的[11.23,23.34],想转换成list类型 阅读全文 » -

python中使用了pandas的一些操作,特此记录下来。 阅读全文 » -

python中使用了numpy的一些操作,特此记录下来。 阅读全文 » -

Python3+Flask+uwsgi部署web服务,实现在新的IP下打开网址 阅读全文 » -

在python中,需要将整数均分成N等分。python divide integers N equal parts sum 阅读全文 » -

在Windows7下需要安装pyspark,写下教程步骤 阅读全文 » -

对于python数组的操作有点混乱,所以特此记录下来 阅读全文 » -

马尔科夫链转移矩阵计算方式 阅读全文 » -

需要将dataframe中的某一行变换为列 阅读全文 » -

scala获取某个时间间隔的时间 阅读全文 » -

Linux查看文件夹大小 阅读全文 » -

需要对dataframe按照某几列为key,对另外几列进行计算,考虑到scala的reduceByKey比groupByKey快速很多,所以使用了这个操作 阅读全文 » -

需要将Spark Dataframe转换为Scala Map集合 阅读全文 » -

Caused by: org.elasticsearch.hadoop.EsHadoopException: Could not write all entries [1/1] (Maybe ES was overloaded?). Error sample... 阅读全文 » -

spark调用distinct只能删除完全相同的行,而需要一种方法按照某几列作为唯一ID来删除重复,利用dropDuplicates可以完美解决这个问题 阅读全文 » -

spark调用elsticsearch的API对elasticsearch进行增删查改 阅读全文 » -

在 hadoop中,基于Linux命令可以给hdfs创建文件和文件夹,或者删除文件和文件夹 阅读全文 » -

spark调用hdfsAPI查询文件名字、删除文件 阅读全文 » -

hadoop使用出现安全模式错误Name node is in safe mode,退出安全模式 阅读全文 » -

在提取dataframe里面的列时,需要传入不定参数,即dataframe.select(args) 阅读全文 » -

github pages一直想添加代码高亮highlighter,基于jekyll 3.0的rouge终于搞定了 阅读全文 » -

System memory * must be at least *.Please increase heap size using the --driver--memory option or spark.driver.memory 阅读全文 » -

python万能库 阅读全文 » -

spark计算两个DataFrame的差集、交集、合集 阅读全文 » -

记录Linux查看的系统的命令,Linux查看系统、核数、CPU、位数 阅读全文 » -

任何一个电子商务公司想要存活下去,必须要时时掌控市场的动态,淘宝天猫上面的商品数据刚好能满足这样子的需求,所以写下这篇抓取教程 阅读全文 » -

特定环境下需要安装Linux suse 11 sp1,走过太多的坑,所以记录下安装的过程方便以后再使用 阅读全文 » -

在抓取网页的时候只想抓取主要的文本框,所以用了一个比较暴力的方法去识别 阅读全文 » -

在抓取网页的时候只想抓取主要的文本框,所以用了一个比较暴力的方法去识别 阅读全文 » -

python之BeautifulSoup使用 阅读全文 » -

selenium操控浏览器下拉到页面最底端 阅读全文 » -

一种去除dataframe中null、NaN和空字符串的方法,基于scala下 阅读全文 » -

chardet库是python的字符编码检测器,能够检测出各种编码的类型 阅读全文 » -

记录python读写2003和2007版本的excel的一些方式 阅读全文 » -

scala时间和时间戳互转 阅读全文 » -

在给代码带包成jar后,放到环境中运行出现No FileSystem for scheme file错误,找到解决办法 阅读全文 » -

在spark中给dataframe增加一列的方法一般使用withColumn,但是个人感觉少了很多功能,不如使用udf 阅读全文 » -

Scala查询dataFrame结构 阅读全文 » -

在使用数据库的时候,需要将查询出来的一列按照逗号合并成一行 阅读全文 » -

日志文件太多,需要清空 阅读全文 » -

安装了 `ubuntu-14` ,为了连接 `xshell` ,做出的一些配置 阅读全文 » -

在scala里面存在 调用Linux命令行的函数,得到返回的结果 阅读全文 » -

在scala中远程连接Linux,并发送相关命令到Linux上,得到返回的结果 阅读全文 » -

`spark` 中的 `reduce` 非常的好用,`reduce` 可以对 `dataframe` 中的元素进行计算、拼接等等 阅读全文 » -

很多人的个人博客用的是多说评论,但是最近多说突然说要关闭了... 阅读全文 » -

网上很多人问绑定域名要不要备案,很多人的回答是... 阅读全文 » -

从数据库提取出来的时间为 `String` 格式,现在需要转换为 `date` 并提取出里面的 *小时* 时间段 阅读全文 » -

为了加密 `.py` 文件,以前一般使用打包成exe ,但是最近发现可以将其编译成二进制文件pyc,虽然反编译难度不大,但是也需要一些水平 阅读全文 » -

python批量启动多线程 阅读全文 » -

Linux发现ctrl+c无法中断程序 阅读全文 » -

scala中spark运行内存不足 阅读全文 » -

scala打包jar并在Linux下运行 阅读全文 » -

scala的input 阅读全文 » -

scala的break和continue 阅读全文 » -

scala合并Array 阅读全文 » -

scala读取配置文件 阅读全文 » -

scala读取解析json文件 阅读全文 » -

scala判断数据类型 阅读全文 » -

IntelliJ的Scala配置 阅读全文 » -

scala的map操作 阅读全文 » -

python获取当前路径 阅读全文 » -

python的StringIO 阅读全文 » -

此方法相当于 `Linux` 系统下的`diff`,或者是 `git` 下的 `checkout` 阅读全文 » -

Linux查找文件内容 阅读全文 » -

python日志syslog运用 阅读全文 » -

python连接Linux命令行 阅读全文 » -

由于 `python` 频繁打印会导致IDE或者系统奔溃,因此将其打印信息写入日志文件中 阅读全文 » -

scala安装教程图文解说 阅读全文 » -

python获取当前运行程序的名字 阅读全文 » -

python获取文件夹名字 阅读全文 » -

python时间和时间戳互转 阅读全文 » -

python判断文件是否存在 阅读全文 » -

python创建递归文件夹 阅读全文 » -

sklearn的kmeans测试代码 阅读全文 » -

当使用库的时候,需要传递不确定个数的参数,那么写法是怎样的? 阅读全文 » -

python安装万能仓库的whl文件出错,原来是文件名弄错了 阅读全文 » -

安装sklearn库需要很多前提条件,而且不能pip3 install sklearn,因此写下教程 阅读全文 » -

Oracle查询得到的时间都是1970...,在python下将其转为时间戳 阅读全文 » -

过年很多人会发微信的红包,但是为毛很多人说自己得不到最佳,因此作者写了一个微信红包发送的算法 阅读全文 » -

在Linux下安装python3且不影响系统的python2 阅读全文 » -

hadoop完全分布式搭建 阅读全文 » -

最为广泛的两种分类模型是决策树模型(Decision Tree Model)和朴素贝叶斯模型(Naive Bayesian Model,NBM),本文讲解朴素贝叶斯 阅读全文 » -

数据挖掘中的ID3决策树算法,再次进行一个初步的学习 阅读全文 » -

虚拟机VMwareWorkstation下安装Linux系统centOS 阅读全文 » -

微信小程序在2017-01-09正式上线,本着跟上时代潮流的精神,写一份教程来看看 阅读全文 » -

埃拉托斯特尼筛法,简称埃氏筛或爱氏筛,是一种由希腊数学家埃拉托斯特尼所提出的一种简单检定素数的算法。要得到自然数n以内的全部素数,必须把不大于根号n的所有素数的倍数剔除,剩下的就是素数 阅读全文 » -

层次聚类是另一种主要的聚类方法,它具有一些十分必要的特性使得它成为广泛应用的聚类方法 阅读全文 » -

K近邻(KNN,k-NearestNeighbor)分类算法是数据挖掘分类技术中最简单的方法之一 阅读全文 » -

以前使用聚类是用spss,现在用python自己写了一次 阅读全文 » -

大数据时代开始流行推荐算法,所以作者写了一篇教程来介绍FP-tree推荐算法 阅读全文 » -

学习了一些chrome插件的基本用法 阅读全文 » -

大数据时代开始流行推荐算法,所以作者写了一篇教程来介绍apriori推荐算法 阅读全文 » -

海龟画图很好看,试着玩了一下 阅读全文 » -

做github静态博客,学习安装jekyll 阅读全文 » -

在破解Amazon的验证码的时候,利用机器学习得到验证码破解精度超过70%,主要是训练样本不够,如果在足够的样本下达到90%是非常有可能的。 阅读全文 » -

妹子要去招聘会工作,奈何网上仅仅提供招聘会的公司名字,没有提供招聘的职位,SO我写了个小代码给妹子在智联上面搜索职位,由于时间紧迫,前程的就不写了 阅读全文 » -

selenium设置浏览器属性 阅读全文 » -

javascript获取浏览器属性 阅读全文 » -

javascript操控浏览器 阅读全文 » -

为了获取网站js渲染后的html,需要利用selenium加载网站,但是会出现加载时间过长的现象,因此可以限制其加载时间以及强制关掉加载 阅读全文 » -

win10安装配置golang 阅读全文 » -

pycharm基本设置,省得每次都要去网上找 阅读全文 » -

百度指数抓取,再用图像识别得到指数 阅读全文 » -

selenium之xpath定位和input文本 阅读全文 » -

selenium在同一浏览器下多个窗口切换 阅读全文 » -

selenium识别下拉框 阅读全文 » -

假如外出工作,需要在另一台电脑上面pull自己的某个git远程项目到本地 阅读全文 » -

妹纸推荐书籍《御伽草纸》,网上找了很久都找不到下载,估计是被Amazon版权了,但是在网易云阅读看到有书,所以就写个代码下载下来。 阅读全文 » -

标签云是现在大数据里面最喜欢使用的一种展现方式,其中在python3下也能实现标签云的效果 阅读全文 » -

RGB颜色对照图 阅读全文 » -

python3的多线程很多人无法理解是怎么运行的,因此本文从程序猿的日常生活出发,写了一个由浅入深的多线程教程,这样子大家就不会觉得陌生了,多线程真的很简单很简单! 阅读全文 » -

selenium是处理异步加载的一种方法 阅读全文 » -

python数据库操作pymysql 阅读全文 » -

详解如何搞定瀑布流 阅读全文 » -

详解如何搞定瀑布流 阅读全文 » -

java从零到变身爬虫大神 阅读全文 » -

github上传本地项目 阅读全文 » -

没事玩了一下matlab 阅读全文 » -

mysql在大学学了,现在忘记得差不多了,复习复习一下 阅读全文 » -

css初学 阅读全文 » -

学习了一些html的基本用法 阅读全文 » -

学习了一些html的基本用法 阅读全文 » -

学习了一些html的基本用法 阅读全文 » -

EDM营销:全称Email Direct Marketing,即电子邮件营销 阅读全文 » -

老板要画雷达图,但是数据好多组怎么办?不能一个一个点excel去画吧,那么可以利用python进行批量制作 阅读全文 » -

markdown初学 阅读全文 » -

在上一篇算法中,逻辑回归作为一种二分类的分类器,一般的回归模型也是是判别模型,也就根据特征值来求结果概率。形式化表示为 p(y|x;θ),在参数 θ 确定的情况下,求解条件概率 p(y|x) 。 阅读全文 » -

在上一篇算法中,线性回归实际上是 连续型 的结果,即 y∈R ,而逻辑回归的 y 是离散型,只能取两个值 y∈{0,1},这可以用来处理一些分类的问题。 阅读全文 » -

今天我们这里要讲第一个有监督学习算法,他可以用于一个回归任务,这个算法叫做 线性回归 阅读全文 »

博客归档

博主梦想

博客日历

网站已运行

|

公元 年 月 农历年 年

|